На самом деле обучение не бывает внезапным, как мы это представили выше, рассматривая сразу обобщенные эталоны.

Можно учить по «чистым» эталонам, объединив их в обобщенные, но реально используются «частные» эталоны, приводящие к одному решению. Например, последовательно применяют эталоны В1&А1&С2, В1&A1&С1 и т.д. и получают решение R1. Можно предъявлять вперемежку разные эталоны, формируя одновременно разные решения.

Например, дядя Рамзай не мог ранее предвидеть некоторых комбинаций событий, предварительно имея ошибочное суждение о распределении работ своих клиентов. Ему даже пришлось употребить свои связи для того, чтобы осуществить вожделенную мечту: включить в орбиту своих действий восхитительную высоко прибыльную продукцию фирмы Ночная бабочка}.

Во всех случаях на этапе обучения целесообразно определять события А, В, С с максимальной достоверностью, равной единице, рассчитывая тем самым реакцию нейросети на вполне определенные ситуации. Ведь даже малая вероятность события, приводящая в рабочем режиме к малой величине возбуждения нейрона входного слоя, указывает на то, что событие возможно и, следовательно, нуждается в рассмотрении и выработке решения. Технология трассировки — «прокладывания» опорных путей в сети также предполагает максимальную достоверность событий.

Сеть, очевидно, должна эволюционировать пополняться и развиваться. Лишь на этой основе можно в дальнейшем ставить вопрос не только об обучении с учителем, но и о самообучении.

Таким образом, мы не сразу предъявляем сети, например, весь обобщенный эталон А1&В1&С1&С2&СЗ&С4&С5, приводящий к решению R1, а последовательно используем частные эталоны как единичные значения соответствующих булевых переменных или целых. Возможно, мы не все эталоны даже можем перебрать практически. Например, спустя год после успешной деятельности компании, Петя впервые направился к Марине, торгующей тибетским бальзамом. Анализ этой ситуации потребовал трассировки решения А2&ВЗ&СЗ

Конечно, проще всего по вновь появившимся частным эталонам сформировать новые обобщенные эталоны и, отвергнув все ранее проведенное обучение (положив все веса связей в нейросети равными нулю), вновь произвести обучение по всему множеству обобщенных эталонов, включая уточненные. Однако это противоречит динамике совокупного процесса обучения и распознавания, непрерывному участию сети в системе управления, увеличению трудоемкости обучения. Обучение должно быть столь же оперативным и динамичным, как и распознавание.

Другой путь учета новых эталонов заключается в "обнулении" или минимизации лишь тех весов связей, которые обусловлены предыдущим значением обобщенного эталона, приводящего к тому же решению. В результате использованные ранее нейроны выводятся в ресурс. Затем трассировка выполняется заново по уточненному обобщенному эталону, что гораздо короче, если не учитывать временных затрат на ликвидацию следов присутствия устаревшего обобщенного эталона.

Рассмотрим проблему динамического включения новых частных эталонов в состав обобщенного на фоне уже произведенного частичного обучения нейросети.

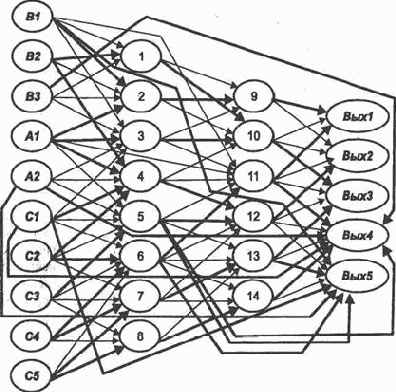

Пусть предъявление эталонов А1&B1&C2 и А1&В1&С4 (обобщенный эталон А1&В1&С2&С4), требующих решения R1, а также предъявление обобщенных эталонов А1&В2&С1&С2&СЗ; А1&В2&С4&С5, A2&B3&C1&C2&C3&C4&C5, А2&В1&С1&С2&СЗ &С4&С5, требующих соответственно решений R2, КЗ, R4, R5, привели к трассировке нейросети, представленной на рис. 4.1. Здесь выделенные связи обладают максимальным значением веса (единичным). Нейросеть получена с помощью алгоритма трассировки, изложенного выше. Матрица следования S, соответствующая получившейся сети, показана на рис. 4.2.

Указанную нейросеть весьма утяжеляют дополнительные связи. Обучение всем обобщенным эталонам сразу (см. разд. 3) выявляет термы, использующиеся при получении различных решений. Здесь же термы не складывались, нейроны почти не использовались повторно. Это и привело к формированию большого числа дополнительных связей.

Пусть в процессе эксплуатации обученной сети выяснилось, что ситуации (эталоны) А1&В1&С1 и А1&В1&СЗ в дополнение к ранее предусмотренным не только возможны, но требуют того же решения R1. Это означает, что обобщенный эталон А1&В1&С2&С4 следует расширить до эталона А1&В1&С1&С2& С5&С4, требующего решения R1, т. е. необходимо построить путь возбуждения (трассу) В\, А\, С\, С2, С3, C4

Нельзя, однако, допускать слияния, влияния строящейся трассы на пути возбуждения, ведущие к другим нейронам выходного слоя, что происходит при повторном использовании нейронов. Ведь слияние двух путей возбуждения заключается в увеличении весов синапсических связей некоторых нейронов. Таким образом, некоторые нейроны могут получать сигналы возбуждения большего, чем прежде, числа нейронов. А если эти нейроны использовались для получения других решений?

В дополнение к алгоритму трассировки заметим следующее. Целесообразно при повторном использовании нейронов в процессе последовательного анализа обобщенных эталонов проследить за тем, участвует ли данный нейрон лишь в одном пути возбуждения к единственному нейрону выходного слоя и к какому именно или к более чем одному нейрону выходного слоя. Этого вполне достаточно.

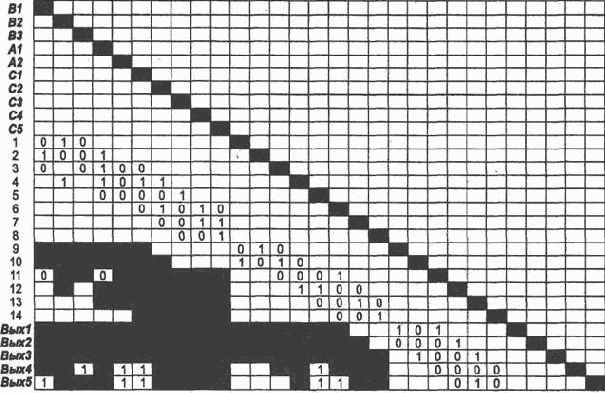

Для нового обобщенного эталона на основе матрицы S построим матрицу

![]() Вых1] (рис. 4.3, а). В соответствии с правилом построения в ней представлены лишь те нейроны, для которых число единиц в строке равно соответствующему значению т. Для каждой строки, содержащей единичные элементы, указано использование нейрона для получения какоголибо единственного решения (признак Вых1) или не единственного (признак отсутствует).

Вых1] (рис. 4.3, а). В соответствии с правилом построения в ней представлены лишь те нейроны, для которых число единиц в строке равно соответствующему значению т. Для каждой строки, содержащей единичные элементы, указано использование нейрона для получения какоголибо единственного решения (признак Вых1) или не единственного (признак отсутствует).

Исключим из построенной матрицы строки и столбцы, соответствующие нейронам, участвующим в путях возбуждения, не ведущих к Вых\ (рис. 4.3, б).

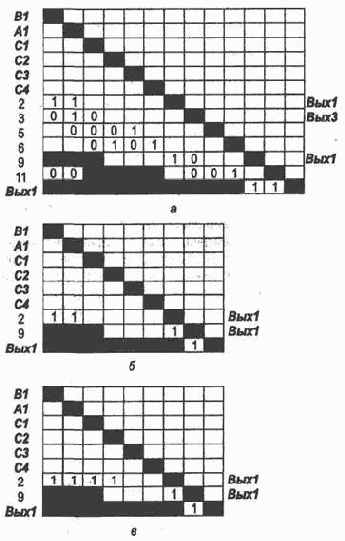

В столбце, соответствующем нейрону С1, и в строке, не являющейся входом, находим первый сверху нулевой элемент. Полагаем его равным единице и отражаем введенное изменение в матрице S. Если нулевого элемента в столбце не нашлось, находим первый «пустой» или отмеченный транзитивной связью элемент и полагаем его равным единице. В результате получаем дополнительную связь С1

То же проделываем с нейроном СЗ, введя дополнительную связь с единичным весом СЗ

Отметим, что наше решение основано на эвристике, и место появления новых возбужденных связей может быть оспорено. Например, могли быть построены связи

![]() 9, или Вых1, СЗ

9, или Вых1, СЗ

![]() 9, или

9, или

![]() Вых1, и т.д.

Вых1, и т.д.

Предлагаем читателю самостоятельно получить уточненную сеть, дополнив рис. 4.1.