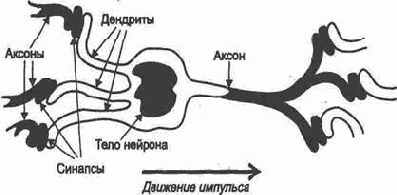

Нейросеть содержит узлы — аналоги нервных клеток — нейронов (нейроподобных элементов, НПЭ) и их соединения — синапсические связи (рис.1.1).

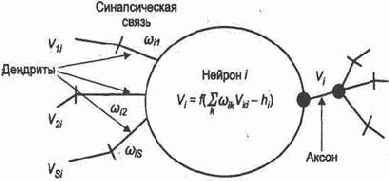

Модель нейрона во взаимодействии с другими нейронами нейросети представлена на рис. 1.2. Здесь

В соответствии с законом распределения энергии величина

Каждый нейрон управляем или извне, или по принципу самоуправления с помощью обратных связей. Можно регулировать значения весов синапсических связей

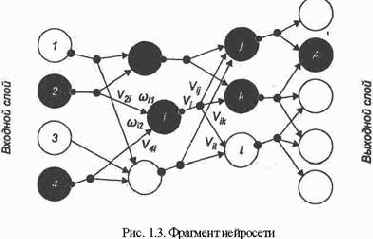

Изображенный на рис. 1. 3 фрагмент нейросети позволяет представить следующее:

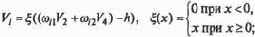

функции f бывают различны, но просты по объему вычислений. В простейшем случае f совпадает с линейной формой — указанным аргументом, т. е. по всем дендритам с учетом их весов (см. рис. 1.3) производится суммирование и сравнение с порогом:

величина превышения порога является величиной возбуждения нейрона или определяет значение величины возбуждения. Например, в некоторых моделях величина возбуждения всегда равна единице, отсутствие возбуждения соответствует нулю. В других моделях допускают и отрицательную величину возбуждения. Значение возбуждения передается через ветвящийся аксон в соответствии со связями нейрона;

в общем случае по дендритам может передаваться как возбуждающее, так и тормозящее воздействие. Первое может соответствовать положительному значению веса синапсической связи, второе — отрицательному. Аналогичный эффект достигается при передаче отрицательных значений возбуждения нейронов;

в сети распознают входной (рецепторный) слой, воспринимающий внешние возбуждения (на который, например, подается видеоизображение), и выходной спой, определяющий решение задачи. Работа сети тактируется для имитации прохождения по ней возбуждения и управления им;

сеть работает в двух режимах:режиме обучения и режиме распознавания (рабочем режиме).

Установим случайным образом начальные значения весов дендритов всей сети. Пусть нейросеть предназначена для распознавания рукописного текста. Тогда входной слой функционирует аналогично сетчатке глаза, которая воспринимает изображение. Его подача на входной слой возбуждает в некоторой конфигурации множество нейронов — рецепторов. Предположим, на входной слой подан и поддерживается некоторый эталон, например буква А. Спустя определенное время максимально возбудится некоторый нейрон выходного слоя (прохождение возбуждения отмечено на рис. 1.3 черным цветом). Закрепим этот нейрон за буквой А, т.е. его возбужденное состояние будем воспринимать как ответ: «Это буква А». Снова введем букву А, но с естественными искажениями, обусловленными почерком, дрожанием руки и т.д.

Возможно максимально возбудится тот же нейрон, а возможно — другой. Мы же хотим «научить» систему, заставить ее ответить, что это тоже буква А, т.е. добиться максимального возбуждения того же нейрона выходного слоя.

Тогда необходимо изменить веса и, возможно, пороги в сети на пути прохождения возбуждения так, чтобы заставить возбудиться нужный нейрон. Такая настройка сети является основным, наиболее важным элементом ее обучением. Применяемые для этого алгоритмы называют алгоритмами обучения.

Одним из наиболее часто применяемых алгоритмов обучения является алгоритм обратного распространения ошибки. В нем воспроизводится подход, используемый в динамическом программировании и основанный на обратном и прямом проходах. Здесь мы предлагаем новый, более простой алгоритм "трассировки", основанный на прямом проходе при прокладывании путей; возбуждения от эталонов к нейронам выходного слоя.

Предъявляя множество эталонов и регулируя параметры, производим обучение сети данному образу. Математические проблемы несовместимости управления параметрами для разных эталонов в данном случае не рассматриваются: в природе такой процесс проходит успешно, достаточно устойчиво при разумном отличии эталонов. Ясно, например, что заставлять один и тот же нейрон выходного слоя возбуждаться и на строчную, и на прописную букву А вряд ли разумно. В лучшем случае он определит, что это вообще буква, а не знак пунктуации.

Обучение заканчивается тогда, когда вероятность «узнавания» достигнет требуемого значения, т.е. необходимость корректировки параметров по предъявляемым эталонам возникает все реже. Теперь можно работать в режиме распознавания. Предъявляем сети различные буквы. Можно быть уверенным, что, если мы предъявим случайно искаженную и даже зашумленную букву А (конечно, в допустимых пределах), сеть ее с большой вероятностью распознает, т. е. максимально возбудится соответствующий нейрон выходного слоя.

Можно существенно облегчить обучение, предъявляя эталон «в полном смысле», т.е., например, показывая букву, регламентированную букварем. Тогда на вероятность распознавания этой буквы будет влиять предусмотренная степень отклонения от данного эталона, обусловленная почерком. Далее необходимо придерживаться именно такого способа обучения.

Расширим функцию входного слоя, связав его не с изображением, а в общем случае с некоторыми характеристиками исходной ситуации (входного вектора), по которой необходимо принимать решение — формировать выходной вектор. Тогда сеть обучается по эталонным ситуациям, решение которых известно, а затем в рабочем режиме выдает решение во всем диапазоне ситуаций и при этом автоматически определяет, на какую «знакомую» ситуацию более всего похожа введенная и, следовательно, какое решение надо принять.

Такая обработка входной информации при возможном использовании в сфере развлечений показана на рис. 1.4.

Отметим, что нейронная сеть выдает заключение в виде ответа на вопрос: «На какую ситуацию похожа данная и, следовательно, какое должно быть принято решение?» Это еще раз подтверждает, что нейросеть имитирует ассоциативное мышление.