|

|

|

|

|

Следующий шаг после задания набора данных и построения подходящей сети - это обучение. В пакете ST Neural Networks реализованы основные алгоритмы обучения многослойных персептронов: методы обратного распространения, сопряженных градиентов и Левенберга-Маркара. Суть метода обратного распространения 1. Алгоритм обратного распространения последовательно обучает сеть на данных из обучающего множества. На каждой итерации все наблюдения из обучающего множества (в данном случае оно совпадает со всем набором данных) по очереди подаются на вход сети. Сеть обрабатывает их и выдает выходные значения. 2. Эти выходные значения сравниваются с целевыми выходными значениями, которые также содержатся в наборе исходных данных, и ошибка, то есть разность между желаемым и реальным выходом, используется для корректировки весов сети так, чтобы уменьшить эту ошибку. 3. Алгоритм должен находить компромисс между различными наблюдениями и менять веса таким образом, чтобы уменьшить суммарную ошибку на всем обучающем множестве, поскольку алгоритм обрабатывает наблюдения по одному, общая ошибка на от- дельных шагах обязательно будет убывать. В пакете ST Neural Networks отслеживается общая ошибка сети—а графике, а также ее ошибки на отдельных наблюдениях на гисто- грамме. Обучение методом обратного распространения 1. Откроите окно График ошибки обучения – Training Error Graph с помощью команды График обучения - Training Graph меню Статистики -Statistics или кнопки (см. рис 4.5).

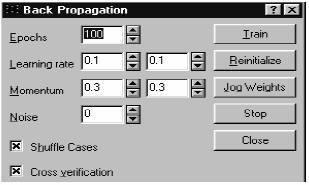

Рисунок 4.5. Обратное распространение

2. Откройте диалоговое окно Обратное распространение - Baсk Propagation с помощью команды Обратное распространение – Back Propagation… меню Обучение многослойного персептрона – Train- Multilayer Perceptron или кнопки . 3. Нажмите кнопку Обучить – Train, в диалоговом окне Обратное распространение – Back Propagation - будет запущен алгоритм обучения. При этом на график будет выводиться ошибка. 4. Повторно нажимайте кнопку Обучить – Train, чтобы алгоритм переходил к очередным эпохам. |

Обучение сети |